Diagnostic Analytics ist der zweite Teil unsere Analytics-Reihe. Diese Analyseform benötigt als Grundlage, die im Beitrag Was ist ‚Descriptive Analytics ausgeführten Modellparameter Objekt, Dimension, Wert und Ereignis. Das ermöglicht den strukturierten und flexiblen Blick auf Vergangenheitsdaten.

In diesen Daten finden sich Situationen, die wiederkehrend sind und entweder vermieden oder gefördert werden sollen. Der nächste Schritt ist die Ursachen identifizierbar zu machen, um dann mit einer Kombination von Dimensionen, Objekten, Werten und Ereignissen eine Benachrichtigung in der Analyse-Lösung einzurichten. Darauf folgt die Identifikation von Maßnahmen, die dem Unternehmen zur Verfügung stehen, um diese Situationen zu vermeiden oder zu verstärken. Ein einfaches Beispiel, in dem dieser Prozess schon vollständig durchlaufen ist, ist ein Kaffeevollautomat: Auch ohne Sensoren fordert die Maschine nach einer bestimmten Anzahl von Bezügen das Leeren des Tresterbehälters an, da er mit hoher Wahrscheinlichkeit gut gefüllt ist. In solchen Maschinen ist die diagnostische sowie die prädiktive Analyse im Kleinen schon abgeschlossen und die zu vermeidenden Zustände sind mit klaren Handlungsanweisungen versehen.

Ein diagnostischer Analyse-Prozess am Beispiel einer Kaffeemaschine könnte also wie folgt aussehen: Das Gerät hat einen Wasserbehälter mit Füllstandsensor, einen Behälter für den Filter mit Kaffee, einen Knopf und eine Kanne. Nach Inbetriebnahme funktioniert alles tadellos, doch irgendwann gibt die Maschine keinen Kaffee mehr aus. Die Gründe dafür sind noch nicht identifiziert und nicht in Relation gebracht.

Um den Prozess der diagnostischen Analyse zu durchlaufen, muss in dem Beispiel der Kaffeemaschine immer wieder der Ausgangszustand hergestellt und jeder Systemzustand beobachtet werden. Nach einer gewissen Menge dieser Durchläufe, entsteht eine Datenbasis, aus der sich Rückschlüsse ziehen lassen: Die diagnostische Analyse wird einen wahrscheinlichen Zusammenhang zwischen dem Füllstand des Wasserbehälters (leer) und dem Eintreten des Ereignisses „Kein Kaffee“ erkennen.

In modernen Vollautomaten ist das zum Glück schon alles durchlaufen, inklusive der nächsten Phasen:

- ‚Predictive Analytics‘: Wenn das Wasser leer ist, wird vermutlich kein Kaffee mehr kommen

- ‚Prescriptive Analytics‘: Die Maschine gibt den Vorschlag: Fülle Wasser nach.

Was bei einem Kaffeevollautomaten mit einer überschaubaren Menge an Zuständen schnell durchleuchtet und in einen funktionalen Prozess gewandelt werden kann, ist in der Intralogistik deutlich schwieriger: Viele Schnittstellen zu anderen Systemen und Unternehmen führen dazu, dass eine zu einfache Diagnose und die daraus abgeleiteten Maßnahmen unter Umständen zu Problemen an anderen Stelle führen.

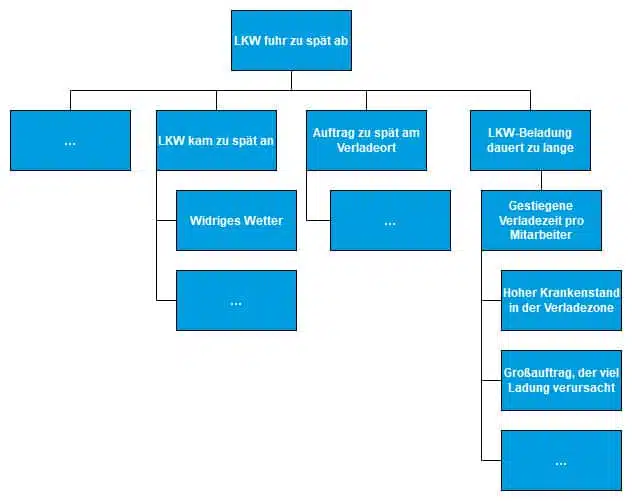

Vereinfachtes Beispiel zu ‚Diagnosic Analytics‘ aus der Logistik

Mithilfe von statistischen Daten aus der deskriptiven Analyse wurde für ein Beispiellager festgestellt, dass die Abfahrtszeit der LKWs mit den zu versendenden Waren ein guter Indikator für die Servicequalität ist: Fährt der LKW pünktlich ab, so ist die Ware pünktlich beim Kunden und die Kundenzufriedenheit gewährleistet. Kommt es zu einer Verzögerung der Abfahrt, erhält der Kunde die Ware zu spät, was zu einem Verlust an Zufriedenheit führen kann. Diagnostic Analytics hilft dabei Vorgänge in den richtigen Kontext einzubetten: Ab und zu gibt es Ausreißer in der Abfahrtszeit. So fuhr gestern ein LKW erst 30 Minuten nach seiner geplanten Abfahrtszeit auch wirklich ab. Der Analyseprozess hilft dabei mögliche Ursachen für diese Ausreißer zu finden. Dabei werden verschiedene Daten(quellen) zu Rate gezogen.

Hier können über das im Beitrag zu ‚Deskriptive Analytics‘ vorgestellente Drill-Down-Verfahren mögliche Erklärungen gefunden werden:

• Der LKW kam schon zu spät an

• Es musste auf einen Auftrag gewartet werden, da dieser zu spät am Verladeort ankam

• Der LKW kam pünktlich an und die Waren war pünktlich am Verladeort, doch die Verladedauer war zu lang

• …

Weiter mit den zwei beispielhaften Strängen: Das widrige Wetter und die zu lange Verladezeit. Es scheint ein Zusammenhang zwischen dem schlechten Wetter und der verspäten Abfahrtszeit zu bestehen. Ebenso zwischen den KPI zu verladende Ladung pro Mitarbeiter und Abfahrtzeit. Was dabei unbedingt berücksichtigt werden muss, ist dass sich dadurch keine absoluten Erklärungen finden lassen sondern eine Wahrscheinlichkeit dafür, dass dies oder jenes der Auslöser sein könnte. Es könnten jedoch auch andere Faktoren aus möglicherweise nicht betrachteten Datenquellen oder eine Kombination von Faktoren eine Rolle spielen.

Die Rolle ‚Data Analyst‘ in Analytics-Prozessen

Vor dem Aufkommen von Methoden des Maschinenlernen musste ein/e Data Analyst/in die Antworten zu den auftretenden Situationen finden indem er/sie händisch mit Fachwissen verschiedene Datenquellen auf Anomalien, Muster und Zusammenhänge untersucht hat, so wie wir es an den beiden einfachen Beispiel der Kaffeemaschine und der verspäteten Lieferung getan haben. Heute unterstützen die Analysten dabei verschiedene Methoden und Algorithmen aus Datamining-Prozessen dabei, die immer größer werdenden Datenmengen zu bewältigen und eben jene Anomalien, Muster und Zusammenhänge zu finden. Trotz maschineller Unterstützung ist immer noch viel Fachwissen erforderlich, sowohl beim Konfigurieren, Erstellen und Auswählen der Datenquellen und Algorithmen als auch beim Bewerten der gefunden Ergebnisse.

Survivorship Bias und andere Fallen in der diagnostischen Analyse

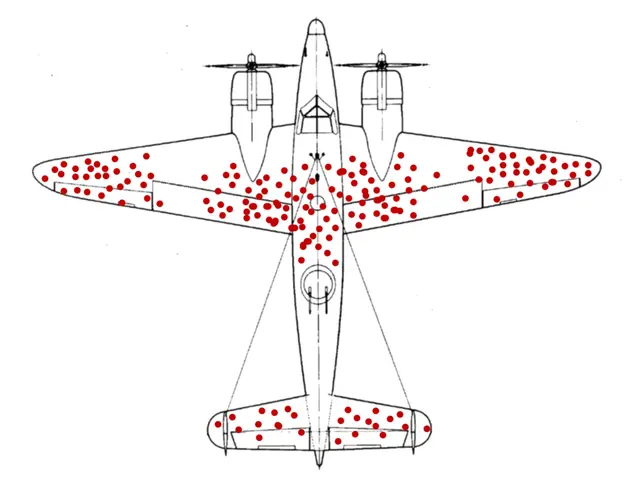

Ein zugängliches Beispiel für die Gefahr von Fehlschlüssen und kognitiver Verzerrung in der Analyse ist der Überlebensirrtum (Eng.: Survivorship Bias). Assoziert ist der Begriff primär mit der statistischen Arbeit alliierter Ingenieure während des zweiten Weltkrieges: Sie analysierten die Treffer an den von einem Einsatz zurückgekehrten Flugzeugen und schlugen nach dem Sammeln von ausreichend Daten vor die Panzerung an diesen Stellen zu verstärken.

Allerdings stieg durch die zusätzliche Panzerung die Überlebensrate nicht. Die Statistiker wurden Opfer einer kognitiven Verzerrung: Die eigentlich Information, die sie durch ihre Analyse gewonnen hatte war „An welchen Stellen kann ein Flugzeug schwer beschädigt werden und noch flugfähig bleiben“. Doch diese Information wurde fehlinterpretiert zu „An welchen Stellen werden Flugzeuge besonders häufig getroffen“.

Erst der Mathematiker Abraham Wald deckte den Fehlschluss auf, in dem er darauf hinwies, dass in diesem Datensatz nur heimgekehrte Flugzeuge berücksichtigt wurden. Seine Handlungsempfehlung war dadurch genau entgegengesetzt: Er schlug vor die Flugzeuge dort zu panzern, wo es die geringsten oder keine Schäden gab. Sein Schluss war, dass Treffer an diesen Stellen zum Verlust des Flugzeug führen und damit auch zum Fehlen als Korrektiv im Datensatz. Seine Arbeit steht inzwischen hier zum Download zur Verfügung, für die statistisch Interessierten. Einen weiteren Eiblick gibt der Beitrag „The Legend of Abraham Wald“ der American Mathematical Society.

Diagnostic Analytics hat das Ziel die Frage „Warum ist es passiert?“ so gut wie möglich zu beantworten

Wo die Kernaufgabe der deskriptiven Analyse, die Aufbereitung von Daten in klare, mit relevantem Kontext angereicherten Strukturen ist, hat die diagnostische Analyse die Aufgabe durch Interpretation möglichst schlüssige Beziehungen zwischen den Zuständen eines Systems und deren Ursachen herzustellen. Bei einer Kaffeemaschine ist das einfach: Das Objekt „Bezug – Kaffee“ verringert den Füllstand des Auffang- und Tresterbehälters. So kann über eine deskriptive Analyse schnell festgestellt werden, dass nach einer bestimmten Anzahl von Bezügen immer der Zustand „Wasserbehälter leer“ eintritt. Ein Zusammenhang zwischen dem leeren Wasserbehälter und dem ausbleibenden Kaffee ist in diesem Fall schnell hergestellt. Während es bei dem zweitwichtigsten Arbeitsgerät der meisten Entwickler auf Füllstand-Management hinausläuft, kommen in der Intralogistik nach Auslastung der Fördermittel, Wegezeiten, verfügbare Packplätze und viele weitere Parameter dazu.

Komplexe Korrelation ist die zentrale Herausforderung der diagnostischen Analyse

Ein einfacher Zustand wie „der Regalplatz ist leer“ kann in der Intralogistik komplexe Erklärungsketten erfordern, die ihrerseits wieder von variablen Bedingungen abhängen. Das Ziel der diagnostischen Analyse ist es möglichst umfassende und vor allem widerstandsfähige Erklärungsmodelle auf der Basis logischer Verknüpfungen, der durch die deskriptiven Analyse gemessene Zustände, zu finden.

Je öfter sich also eine Annahme als korrekt erweist und in den Gegenwartsdaten verifiziert ist, desto wertvoller ist sie in der diagnostischen Analyse. Die weiteren wichtigen Parameter sind Kontext und Korrelation, denn so werden Ursachen von Begleiterscheinungen getrennt und nach Wichtigkeit priorisiert.

So ist eine verspätete Abfahrt auf Grund von Engpässen in der Fördertechnik wichtiger als eine Verzögerung auf Grund schlechten Wetters. Die Handlungsfähigkeit des Unternehmens gegenüber dem identifizierten Problem bestimmt dessen Priorisierung im Analyseprozess. Daher startet der Recherchezweig „Schlechtes Wetter“ von vorneherein mit weniger Ressourcen und wird auch früher abgeschlossen, während der Zweig „Engpässe in der Fördertechnik“ bis ins Detail analysiert wird.

Wie diagnostische Analyse in der Intralogistik eingesetzt werden kann

Die zentrale Aufgabe der diagnostischen Analyse ist es die richtigen Kontextinformationen zu den einzelnen intralogistischen Kennzahlen zur Verfügung zu stellen. Für die Analyse ist es wichtig Detailfragen und Kriterien (z.B. wie das Teil verpackt ist oder ob es ein hohes Gewicht

hat) zu klären, da es ein wichtiger Faktor in der Analyse ist, ob es der erste Pick von 100 oder der eines Einzelteils ist oder ob beispielsweise eine Windschutzscheibe oder ein Kleinteil gepickt wird. Für die Qualität der Analyse ist die frei wählbare Granularität entscheidend, da sich je nach Betrachtungstiefe weitere Muster erkennen lassen.

Die dafür relevanten Objekte sind in den meisten Fällen die folgenden:

- Vereinahmung

- Auftrag

- Inventur

- Pick

- Transport

- Packstück

- Versandeinheit

Die diagnostische Analyse ermöglicht es die zentralen logistischen Objekte mit relevantem, stakeholderbasiertem Kotext anzureichern und daraus Rückschlüsse über auftretende Situationen im Distributionszentrum oder Lager zu treffen.

Zur Beitragsübersicht

Zu unserer TUP-Reihe KI

Zurück zur Startseite

Quelle Teaserbild: Burak K